文章图片

【Java|不花一分钱 老显卡帧率翻倍!以后所有玩家都欠AMD一句谢谢】

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

文章图片

不论你现在使用的是什么品牌的显卡 , 玩的是什么样的游戏 。

大概率再过一个月 , 你不用换显卡 , 不用超频 , 不用刷驱动 。

游戏帧率就能平白翻一番 。

到时候不知道那些奸商们会不会哭死 。

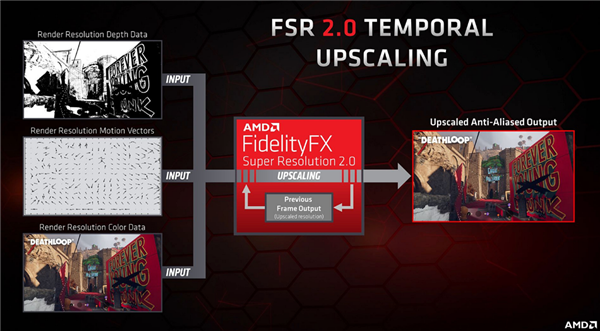

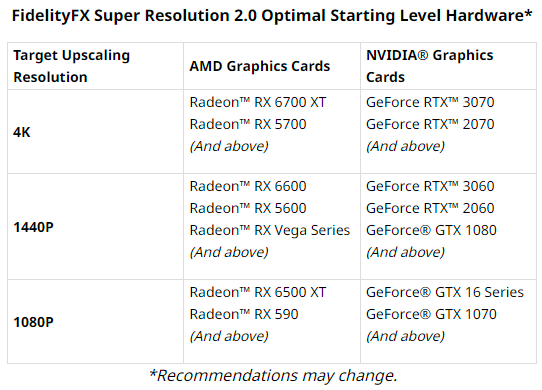

其实啊 , 这一切都要归功于 AMD 即将发布的一项新技术 —— FSR 2.0 。

看到这儿 , 可能就会有小伙伴说了:

我知道 , 去年 AMD 不就发布过一个 FSR 1.0 技术嘛 。

鸡肋一个 , 散了散了~

欸~且慢!去年的 FSR 1.0 的确是个没什么卵用的鸡肋技术不假 , 这我承认 。

但是这次的 FSR 2.0 虽然版本号只进了一位数 , 可它跟它的前辈是完全不同的两样东西 。

然而就是这么个王炸级别的 FSR 2.0 , 我搜遍全网都没见到几个人跟大家深入的聊一聊 。

那么 , 就由我差评君来跟大家抛砖引玉吧~

( 前摇略长 , 有熟悉这段故事的小伙伴可以直接跳到下一节 )

>/ 改变帧数玩法的 AI 超采样

在正式聊 FSR 2.0 是个什么玩意之前 , 咱们得先把时间轴往回拨一拨 。

看一看 2018-2019 年间 , 隔壁英伟达发布的另一样技术:DLSS 。

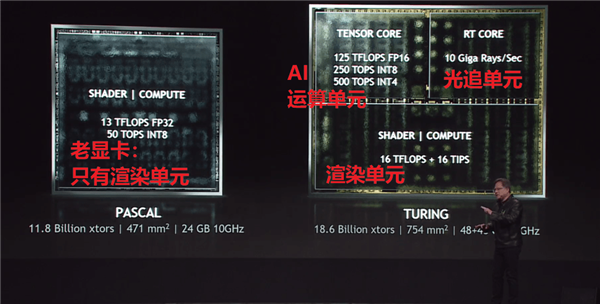

是这么回事 , 从 2018 年底开始 , 英伟达陆续发布了一系列新的 RTX 20 系游戏显卡 。

在这个系列当中 , 游戏显卡除了拥有传统的图形计算单元之外 , 还首次集成了专门用于 AI 计算的独立单元 。

有了这个独立的 AI 计算单元 , 也就是 “ Tensor Core ” 之后呢 , NVIDIA 整出了一个让大家前所未见的操作:

在一些个特定的游戏里 , 显卡渲染的只是 720p 分辨率的游戏画面 , 但是输出到显示器上我们看到的 , 却是 1080p 清晰度的画面 。

同样 , 显卡渲染 1080p 分辨率的游戏画面 , 最终呈现的却是 4K 分辨率的画面 。

这中间相差了四分之三的像素空白 , 是硬生生被显卡里的那个 AI 运算单元给算出来填进去的!

这项技术 , 被 NVIDIA 命名为深度( Deep )学习( Learning )超( Super )采样( Sampling ) 。

也就是我们前面提到的 DLSS 了 。

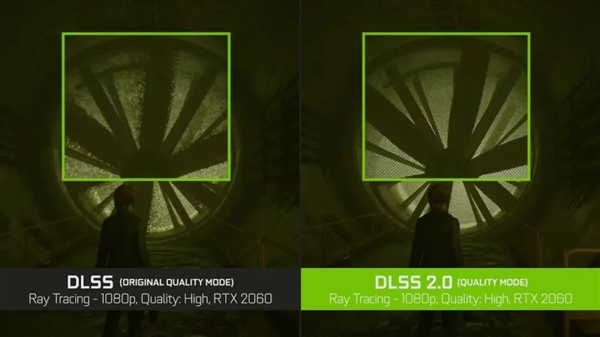

由于四个像素里 , 有三个要靠猜 , 所以一开始 DLSS 有不少猜错了翻车的情况出现 。 (比如上面图左侧框内的模糊)

不过后来随着技术迭代 , 到目前的 DLSS 2.4 技术输出的画面已经和传统运算渲染的没什么区别了 。

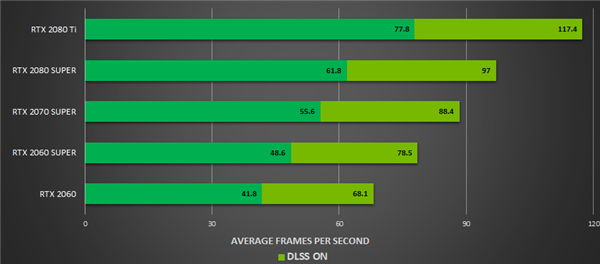

而且这个玩意的效率是很恐怖的 —— 在那些支持 DLSS 的游戏里 , AI 超采样辅助渲染画面的帧数对比传统方法能直接翻倍 。

正是因为有了 DLSS , 我家里那台两年前的 RTX 2060 游戏笔记本才一直扛到了现在 。

>/ 红色阵营的大格局反击

不过凡事都有两面 , DLSS 虽然厉害 , 但也有着两条令人难过的限制:

首先 , 它的运算必须由独立的 AI 运算单元处理 , 也就是说 , 只有 NVIDIA 的 RTX 系列显卡能享受到这项技术 。

- Java|微信原来藏了一个会“震”的小彩蛋?

- 影驰|买手机选“低配版”还是“高配版”?区别在这3点,不花冤枉钱

- TCL|【Java面试题】大厂面试必问的Spring 问题你来问,我来答!

- iOS|为什么Java是企业应用程序开发的最佳选择?

- 高通骁龙|Java 开发人员所需的技能

- Java|当下最强的拍照旗舰盘点:顶级硬件+自研芯片,选这三款错不了

- Java|Java工程师学习路线是怎么样的?能快速掌握吗?

- Java|影驰RTX 3090 Ti星曜OC显卡评测:闪耀旗舰,由你创作

- Java|iPhone电池做大,完全可以,和安卓的续航媲美

- Java|Java有什么不同的用途?